El problema (estructural) de ChatGPT y OpenAI

3 de enero de 2026

Crecimiento sin precedentes, costos sin precedentes, monetización aún incierta

En las últimas semanas volvió a circular una cifra que, por sí sola, obliga a detenerse: OpenAI proyecta un flujo de caja negativo acumulado cercano a USD 140 mil millones entre 2024 y 2029, antes de alcanzar rentabilidad, según estimaciones citadas por Deutsche Bank y EMARKETER.

Para ponerlo en perspectiva histórica:

Uber: ~USD 18B de pérdidas en ~6 años antes de ser cash-flow positivo

Tesla: ~USD 9B en ~9 años

Amazon: ~USD 1B antes de despegar

OpenAI: una escala completamente distinta, un orden de magnitud mayor

La comparación no busca dramatizar, sino entender por qué la economía de la IA generativa es diferente a cualquier otro ciclo tecnológico previo.

1. El corazón del problema: costos variables que no escalan bien

A diferencia del software tradicional, cada uso de un modelo de IA tiene un costo marginal significativo:

Entrenamiento: decenas de miles de GPUs, meses de cómputo, costos energéticos masivos.

Inferencia: cada prompt, cada respuesta, cada usuario concurrente consume cómputo real.

Latencia y calidad: competir exige modelos más grandes, más razonamiento, más pasos de inferencia → más costo por request.

En SaaS clásico, crecer usuarios reduce el costo unitario.

En IA generativa, crecer usuarios puede aumentar la quema de caja si no hay monetización proporcional.

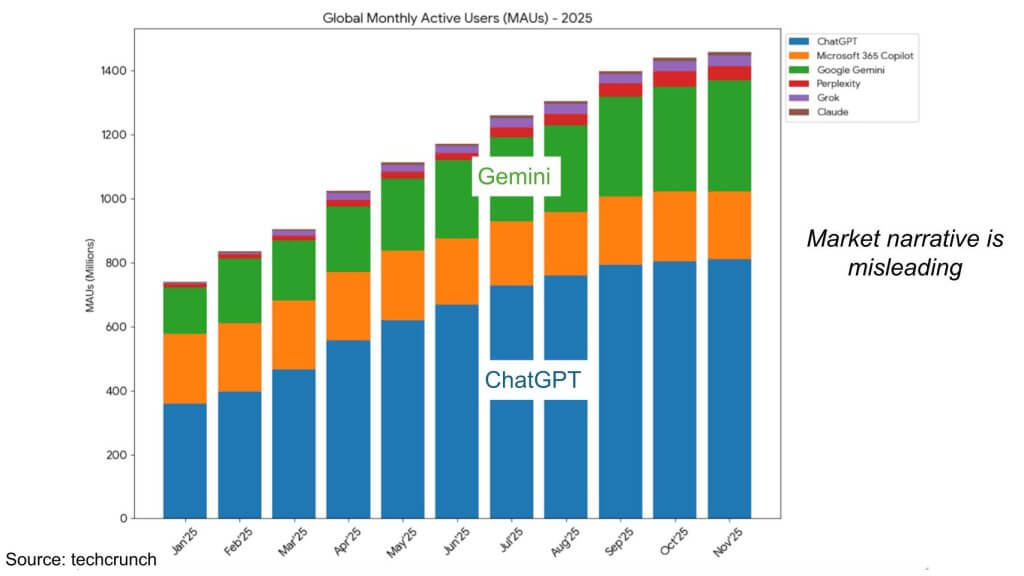

2. Mucha adopción… pero demasiado uso gratuito

OpenAI logró algo extraordinario: poner IA avanzada en manos de cientos de millones de personas.

Pero ese éxito trae una paradoja:

Gran parte del uso sigue siendo free o altamente subsidiado

El willingness to pay del usuario promedio es bajo

El usuario power (empresas) sí paga, pero exige SLAs, seguridad, privacidad y customización, lo que vuelve a subir costos

Resultado:

📈 Adopción masiva

📉 Unit economics frágiles

3. Competir contra jugadores con “balance infinito”

El competidor más cercano hoy no es una startup, es Google / Alphabet.

Google tiene:

Infraestructura propia (TPUs, data centers, energía)

Cash flows gigantes desde Search

Capacidad de subsidio cruzado

Pero incluso Google enfrenta su propio dilema:

👉 canibalizar el negocio de búsqueda, uno de los flujos de caja más rentables de la historia.

OpenAI, en cambio:

No tiene un “core business” legacy que financie la transición. Depende de capital externo para sostener la curva de costos

4. El IPO como puente, no como solución

Se ha reportado que OpenAI estaría evaluando un IPO del orden de USD 100B, una cifra 4x mayor que los mayores IPOs históricos, según análisis citados por The Economist.

El punto clave:

💡 El IPO no resuelve el problema económico, solo compra tiempo.

Ese capital serviría para:

Financiar infraestructura

Seguir entrenando modelos frontera

Ganar tiempo para encontrar un modelo de monetización sostenible

Pero el mercado público será menos indulgente que el venture capital.

5. El verdadero dilema estratégico

OpenAI enfrenta una decisión de fondo:

¿Qué quiere ser en 10 años?

Infraestructura base de la economía digital

Margen bajo

Volumen altísimo

Similar a cloud o utilities de IA

Plataforma premium empresarial

Menos usuarios gratis

Tickets altos

Integración profunda en procesos críticos

Ecosistema híbrido (modelo + marketplace + agentes)

Más defensabilidad

Pero también más complejidad operacional

Cada camino implica estructuras de costos, pricing y producto completamente distintas.

6. Lo que este caso nos enseña (más allá de OpenAI)

Este no es solo un problema de OpenAI. Es una señal para todo el ecosistema:

La IA no es software tradicional

La adopción no garantiza rentabilidad

La estrategia de monetización es tan importante como el modelo

Para startups, corporaciones y fondos de VC, la lección es clara:

En la economía de la IA, la pregunta no es “qué tan inteligente es el modelo”, sino “quién paga el costo de que sea inteligente”.